defame Fakes: Projekt zur Erkennung von Deepfakes und Manipulationen

Deepfakes gefährden die Demokratie und fordern Staat, Gesellschaft und Unternehmen heraus. Das Projekt defame Fakes verspricht Lösungsansätze.

Mit dem Projekt defame Fakes verfolgt das Austrian Institute of Technology (AIT) mit seinen Projektpartnern ein umfassendes Ziel: Es möchte Deepfakes – daher sehr real wirkende multimediale Fälschungen - in digitalen Bild- und Videoinhalten leichter erkennen. Dadurch könnte die Verbreitung von Desinformation und anderen problematischen Inhalten zwar nicht verhindert, deren Reichweite und Wirkungsgrad jedoch deutlich abgeschwächt werden. Neben der Forschung und Entwicklung von technischen Hilfsmitteln umfasst das Projekt auch Maßnahmen, um das Problembewusstsein in der Bevölkerung zu schärfen und so die Medienkompetenz landesweit zu stärken.

Lesen Sie für weitere Informationen folgende Beiträge:

Mehr Sicherheit durch Tools und Aufklärung gegen Deepfakes

Das Projekt konzentriert sich auf die Erforschung und Entwicklung von Tools zur halbautomatischen Erkennung von Deepfakes in großen Datensätzen. Bild- und Videomanipulationen sollen zukünftig zuverlässig identifiziert und deren Gefährdungspotenzial rascher eingedämmt werden. Dadurch kann die demokratische Gesellschaft besser vor Desinformation geschützt werden.

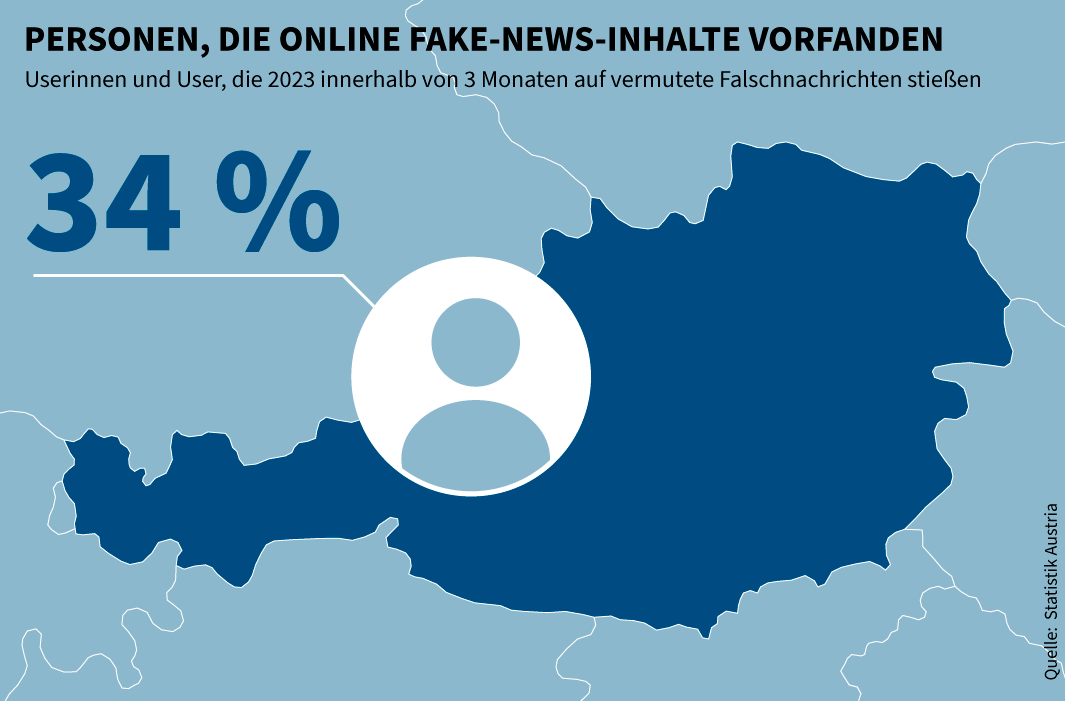

Parallel zur Entwicklung medienforensischer Detektionstools sollen Aufklärungskampagnen starten, um einen breiten gesellschaftlichen Diskurs über die Risiken von Deepfakes anzuregen. Ziel ist es, die Öffentlichkeit für diese Bedrohung zu sensibilisieren (Awareness-Bildung). Als Nebeneffekt soll das Vertrauen in digitale Inhalte wieder steigen.

Überprüfen Sie Ihr kritisches Urteilsvermögen in Bezug auf Medieninhalte im Internet mit dem kostenlosen Online-Test Der-Newstest.at.

Mit Medienkompetenz und Online-Tools gegen Desinformation

Bild- und Videomanipulation können heute mithilfe von Artificial Intelligence leichter als je zuvor hergestellt werden. Neben Programmen wie DeepFaceLab oder Stable Diffusion können auch Gesichtsfilter, die auf Social-Media-Plattformen wie TikTok integriert sind, für Bild-Manipulationen verwendet und missbräuchlich eingesetzt werden. Die Fälschungen wirken dabei täuschend echt.

In den wenigsten Fällen stehen dabei harmlose Unterhaltungszwecke im Vordergrund. KI-basierte Videomanipulationen können beispielsweise genutzt werden, um falsche Behauptungen im Netz zu verbreiten, Politikerinnen und Politiker zu diskreditieren und Wahlgänge zu beeinflussen.

Die Gesellschaft muss sich vor diesem Hintergrund mit künstlicher Intelligenz als Werkzeug der Desinformation kritisch auseinandersetzen. Dies betrifft die öffentliche Verwaltung, Medienorganisationen, die Privatwirtschaft, aber auch Bürgerinnen und Bürger. Nur durch die Beteiligung aller können demokratische Strukturen vor hybriden Angriffen geschützt werden.

Eckdaten zum Projekt defame Fakes

Ein interdisziplinäres Team aus Expertinnen und Experten ist mit der Projektumsetzung beauftragt. Die Umsetzung des Projekts ist für den Zeitraum 01.02.2024 bis 31.01.2026 angesetzt. Finanziert wird die Initiative im Rahmen des Sicherheitsforschungsprogramms KIRAS des Bundesministeriums für Finanzen (BMF).

In enger Kooperation mit dem Bundesministerium für Inneres (BMI) und dem Bundesministerium für Landesverteidigung (BMLV) arbeiten weitere Partner mit, darunter das Austrian Institute of Technology (AIT), die Austria Presse Agentur (APA), PricewaterhouseCoopers (PwC), das Kompetenzzentrum Sicheres Österreich (KSÖ) und das Österreichische Institut für Angewandte Telekommunikation (ÖIAT).

Weitere Informationen und Kontaktadressen finden Sie auf Deepfakes.at.

Für den Inhalt verantwortlich: A-SIT Zentrum für sichere Informationstechnologie – Austria